专为 AI 推理时代而打造

ASUS AI POD 搭载 NVIDIA GB300 NVL72

ASUS AI POD 搭载 NVIDIA GB300 NVL72,将 72 个 Blackwell Ultra GPU 和 36 个 Grace™ CPU 集成到液冷机架式平台中,旨在将 AI 工厂扩展到全新的水平。专为测试时缩放和先进的AI推理而设计,提供推动新一代生成式AI、大语言模型和科学突破所需的计算密度和效率。

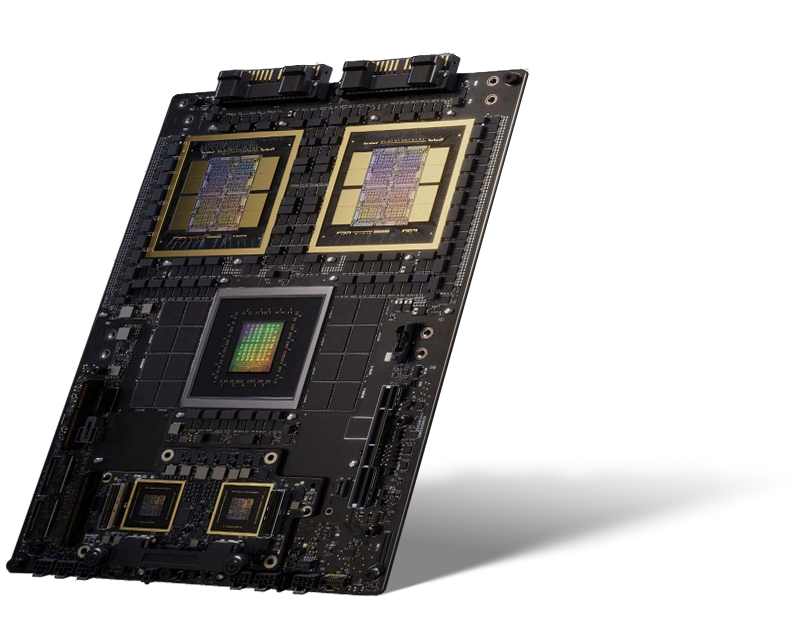

NVIDIA Blackwell Ultra GPU 突破算力瓶颈

NVIDIA GB300 Grace Blackwell Ultra 超级芯片具有 2080 亿个晶体管,采用双倍光刻极限尺寸的裸片,通过 10 TB/s 的片间互联技术连接成一块统一的 GPU。与 NVIDIA Blackwell GPU 相比,具备 288GB HBM3e 和 1.5 倍的 AI 计算能力,可实现更大的上下文窗口、更快的推理速度和突破性的可扩展性,为下一代 AI 模型提供高达 NVIDIA Hopper 平台 50 倍的推理性能。

-

-

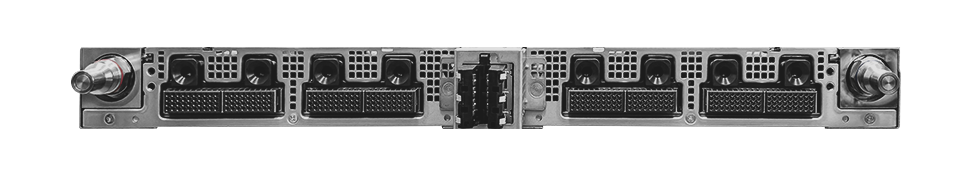

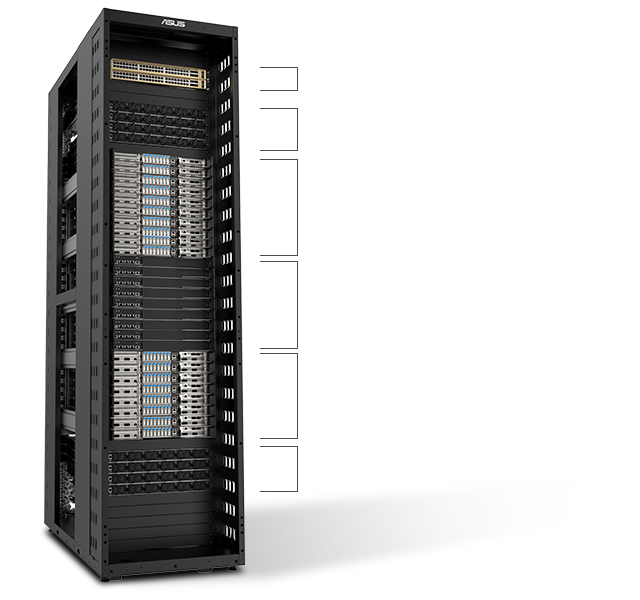

2 x OOB MGMT 交换机 1GBe

1 x OS 交换机 1GBe (选配)3 或 4 x 1RU 电源架 33KW

10 x 计算托盘

• 4 x NVIDIA Blackwell Ultra GPU (每托盘)

• 2 x NVIDIA Grace GPU (每托盘)9 x NVLink 交换机托盘

• 互连 72 x GPU 具备 1,800 GB/s, 第5代 NVLink8 x 计算托盘

• 4 x NVIDIA Blackwell Ultra GPU (每托盘)

• 2 x NVIDIA Grace CPU (每托盘)3 或 4 x 1RU 电源架 33KW

-

XA GB721-E2 提供无缝的 GPU 间通信和加速的数据传输,构建统一的高性能架构。这些技术共同提供快速、高效且可靠的连接能力,为AI超算基础设施释放可扩展的性能。

第五代 NVIDIA NVLink™

实现无缝的GPU间通信,释放全新水平的推理性能。

NVIDIA Quantum-X800 InfiniBand /

NVIDIA Spectrum-X™ Ethernet

搭配 NVIDIA ConnectX®-8 SuperNIC™ 提供出色的 RDMA 技术,实现峰值 AI 工作负载效率。

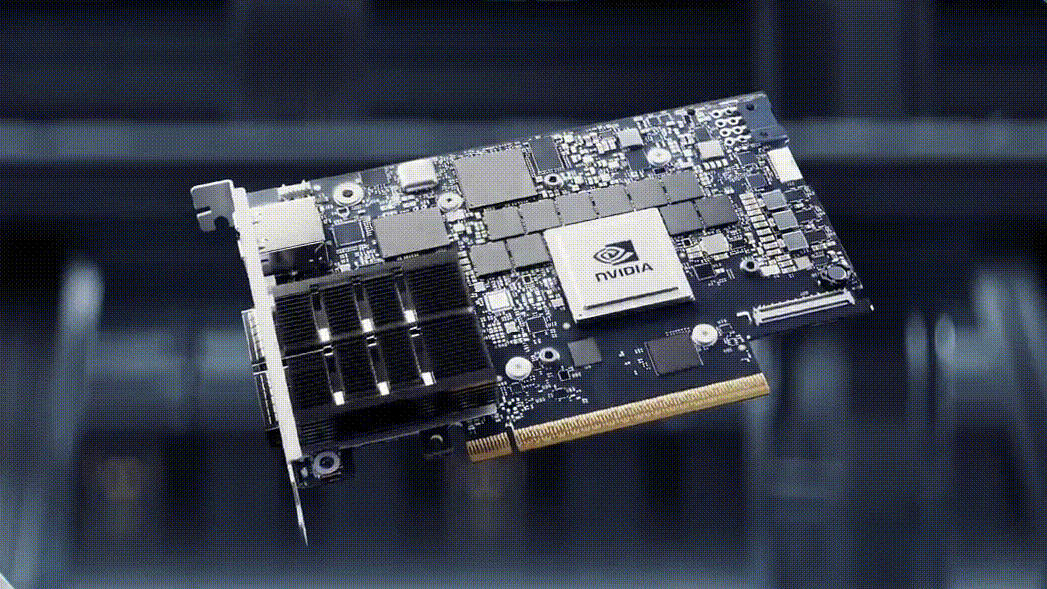

NVIDIA® BlueField®-3

通过云网络和敏捷可组合存储,实现基础设施转型。

全面解决方案,加速产品上市

除了全面的硬件配置外,华硕还针对 ASUS AI POD 提供完整的软件、存储、网络、散热及管理服务套件。这种一体化方案可简化运营流程,助力快速部署,并赋能企业加速人工智能创新,缩短产品上市周期。

优化效率,减少热量

水冷架构

NVIDIA GB300 Grace Blackwell Ultra 超级芯片具有 2080 亿个晶体管,采用双倍光刻极限尺寸的裸片,通过 10 TB/s 的片间互联技术连接成一块统一的 GPU。与 NVIDIA Blackwell GPU 相比,具备 288GB HBM3e 和 1.5 倍的 AI 计算能力,可实现更大的上下文窗口、更快的推理速度和突破性的可扩展性。NVIDIA GB300 NVL72 为下一代 AI 模型提供高达 NVIDIA Hopper 平台 50 倍的推理性能。

-

液冷至风冷解决方案

适用于设施紧凑的小型数据中心。

专为满足现有风冷数据中心的需求而设计,可轻松集成到现有基础设施中。

非常适合需要立即实施和部署的企业。 -

液冷至冷解决方案

适用于工作负载高的大型、广泛的基础设施。

提供长期、低PUE值,并随时间推移保持持续的能源效率。

降低总体拥有成本,实现更大价值和经济高效的运营。

经验证的拓扑

实现可扩展的AI基础设施

华硕AI POD搭载NVIDIA GB300 NVL72,采用经过验证的参考架构,可简化网络拓扑部署,确保性能可预测性并实现简易扩展。

更多服务

可预测的性能

为高要求的人工智能工作负载提供保障带宽和低延迟

简化缩放

经过验证的设计确保从机架到集群的平稳扩展

部署效率

参考架构可加速部署并降低复杂性

加速上市时间

华硕自带软件和控制器

NVIDIA NVLink 交换机配备144个接口,交换容量达14.4 TB/s,可在单个NVLink域内将九台交换机与72块NVIDIA Blackwell Ultra GPU上的NVLink接口互连。

-

ASUS Control Center (ACC)

集中式IT管理软件,用于监控和控制华硕服务器

- Power Master - 为数据中心提供有效的能源控制

- 轻松搜索和控制设备

- 轻松快捷地增强信息安全

-

什么是搭载 NVIDIA GB300 NVL72 的 ASUS AI POD?什么是搭载 NVIDIA GB300 NVL72 的 ASUS AI POD? 搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 是一款机架级AI基础设施解决方案,集成了72 NVIDIA Blackwell Ultra GPU和36 NVIDIA Grace CPU,可为大规模LLM推理、训练及AI推理提供强大算力支持。

-

搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 如何提高 AI 性能?搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 如何提高 AI 性能? NVIDIA GB300 NVL72 通过第五代 NVIDIA NVLink™ 及 ConnectX-8 SuperNIC,配合 Quantum-X800 InfiniBand 或 Spectrum-X™ Ethernet,实现无缝 GPU 通信、低延迟与高带宽数据流,从而加速训练与推理过程。

-

搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 有哪些散热选项?搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 有哪些散热选项?搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 同时支持液冷至风冷与液冷至液冷散热方案,确保在严苛的AI工作负载下实现高效散热与稳定性能。

-

搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 是专为数据中心和企业级AI设计的?搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 是专为数据中心和企业级AI设计的?搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 专为企业级AI、超大规模数据中心、云服务提供商及科研机构优化设计,可为万亿参数大型语言模型、模态增强(MoE)及其他高要求AI应用提供可扩展性能。

-

搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 包含哪些服务?搭载 NVIDIA GB300 NVL72 的 ASUS AI POD 包含哪些服务? 除了硬件外,华硕专业服务还涵盖软件集成、存储解决方案、网络拓扑设计、散热技术支持及部署服务,助力企业加速产品上市进程。