推动数据中心进入加速计算新时代

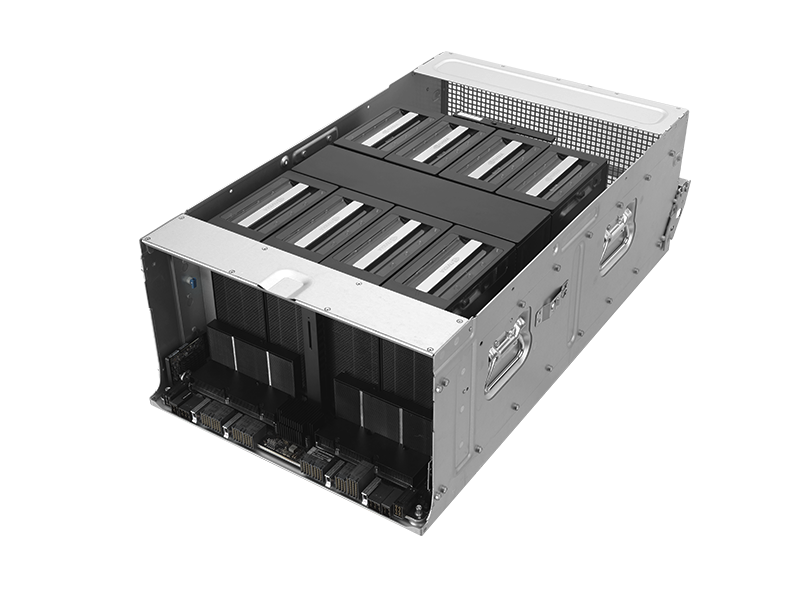

NVIDIA Blackwell HGX™ B200

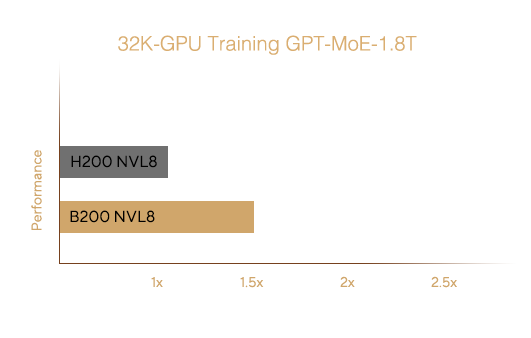

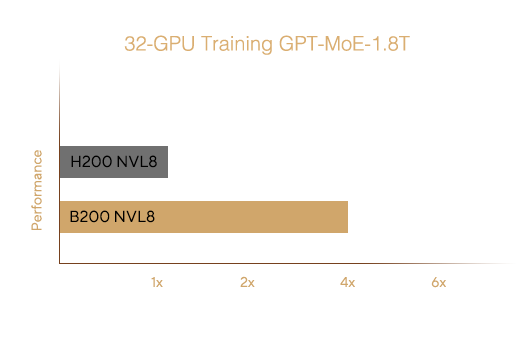

大规模训练

大规模推理

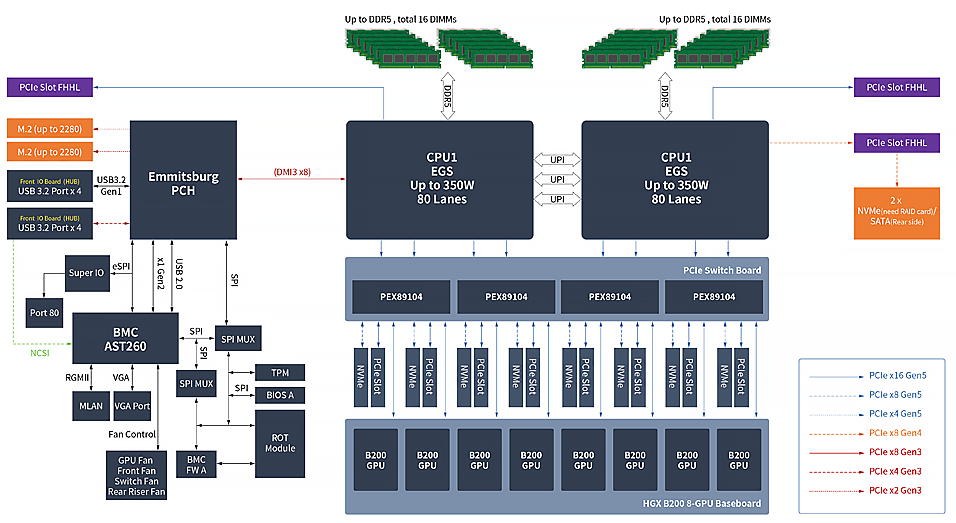

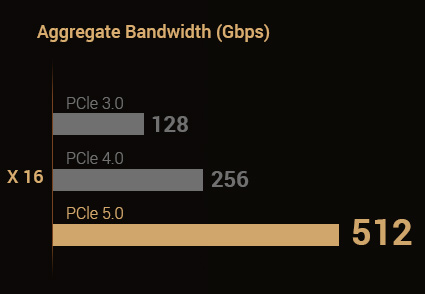

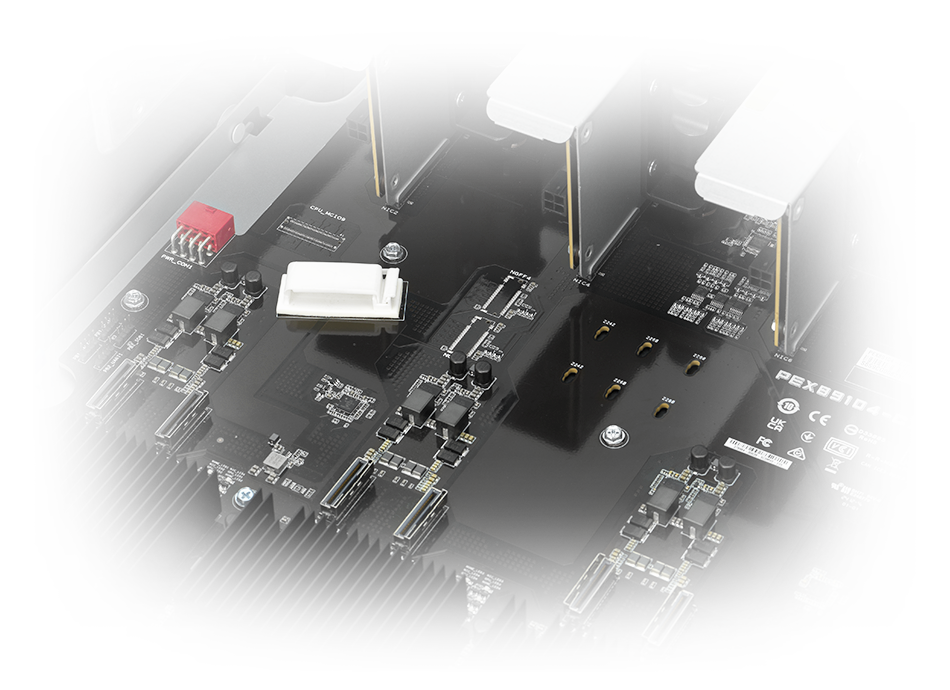

支持 PCIe 5.0

更快的存储、图形和网络功能

1,800 GB/s 带宽

通过 NVLink 进行 GPU 对 GPU 直接互连

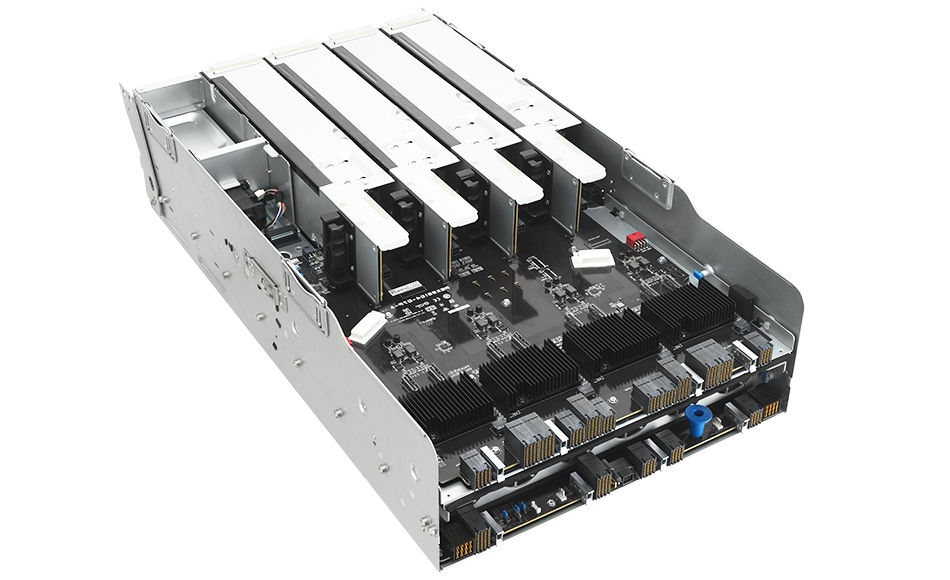

PCIe 5.0 交换板 (switch board) 可更快

连接存储设备、显卡和 NIC

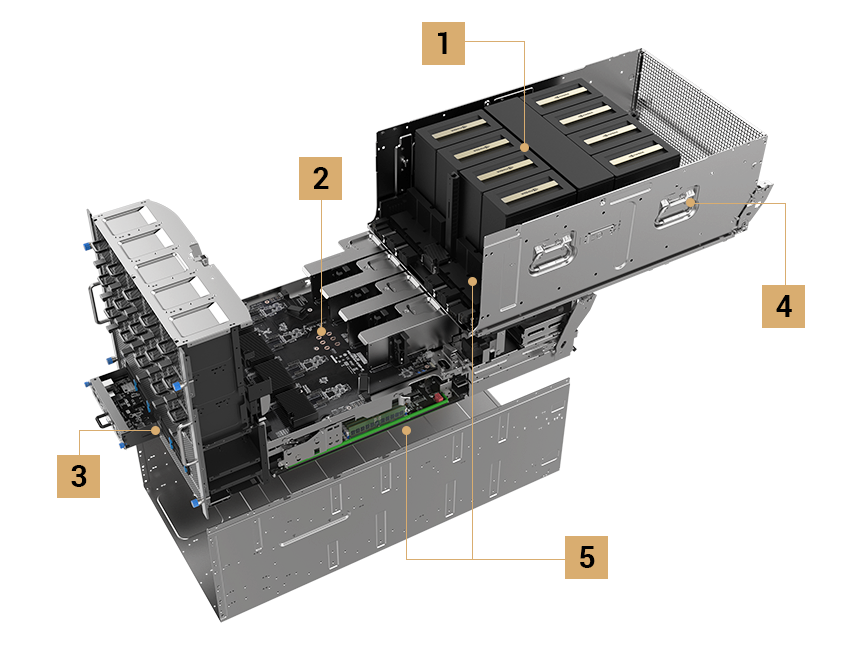

10 个 NVMe 存储设备

- 前面板 8 个

- 后面板 2 个

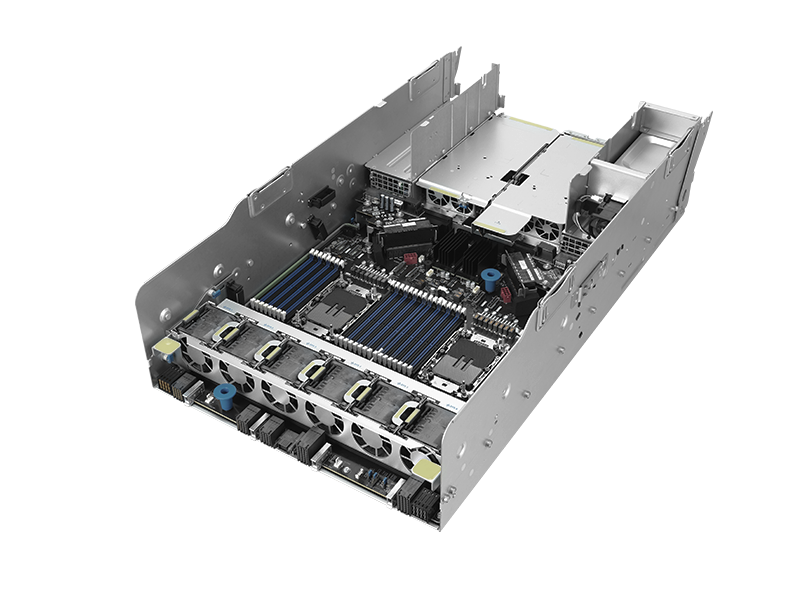

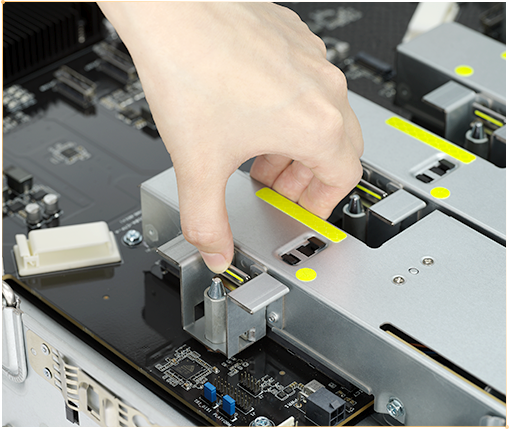

模块化和免工具设计

搭配滑轨式设计和手把

独立气流通道设计

搭配双转子风扇模块

GPU 滑架风扇 8080 x 15 个

NVMe x 8

NVMe x 2

1 x PCIE Gen4 x 8

8 x PCIe Gen5 x16 (LP)

2 x PCIE Gen5 x 16

PSU x 6

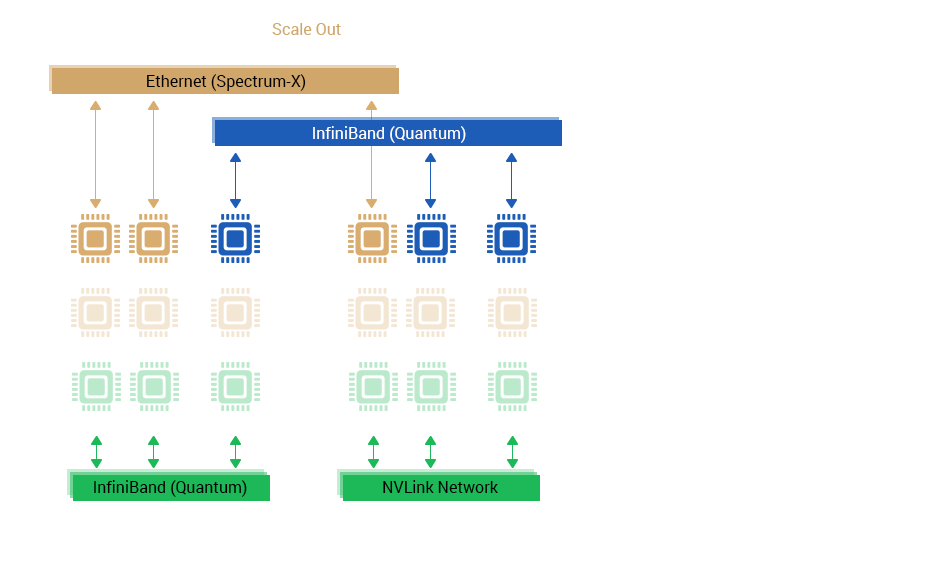

1 GPU 对 1 NIC 拓扑

单一系统即可支持 8 个 NIC 和 8 个 GPU

模块化设计,减少线材使用

轻松排除故障,并达到导热优化

先进的 NVIDIA 技术

充分使用 NVIDIA GPU、DPU、NVLink、NVSwitch 和网络技术

可持续性

让您的数据中心维持环保节能

优化的散热设计

双层 GPU 和 CPU 滑架可提升导热效率

5+1 电源

高电源效率

可维护性

提升 IT 营运效率

-

符合人体工学的手把设计

-

免工具手旋螺丝

-

转接卡卡扣

-

免工具外盖

管理

全方位 IT 基础架构解决方案

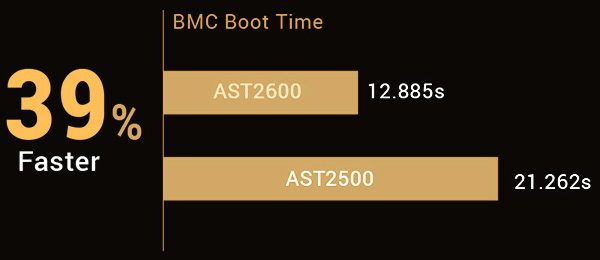

BMC

远程服务器管理

IT 基础架构管理软件

通过单一仪表板简化 IT 营运

硬件信任根解决方案

侦测、恢复、启动和保护

* 平台固件弹性 (PFR) 模块必须在订购时指定并在原厂安装,并无单独出售。

性能

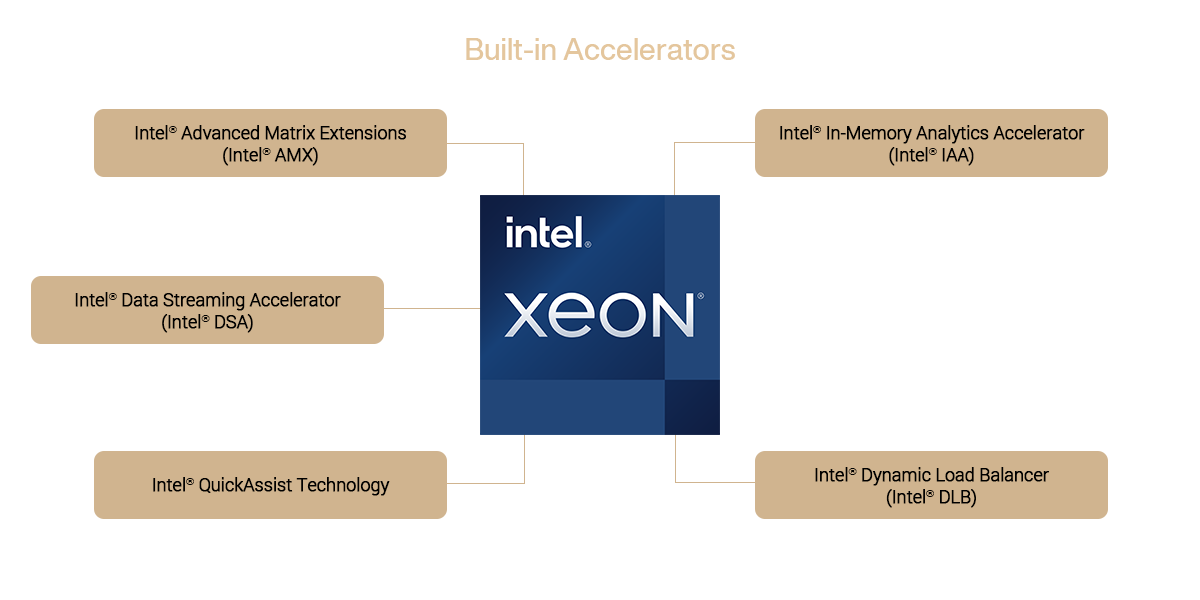

第5代英特尔® 至强® 可扩展处理器

* 加速器的可用性因 SKU 而异。